Apple en la convención del WWDC 2019 lanzó una serie de herramientas de realidad aumentada y lo mejor de todo es que se genera esto bajo la base de su SDK, ARKIT 3 se ha renovado para potenciar más experiencias inmersivas. En este post mencionaré los ejemplos que han aparecido en twitter de los primeros programadores con acceso al beta de ARKit 3 y claro al iOS 13.

RealityKit servirá para simular y renderizar 3D con una gran capacidad. Nos ayudará a integrar objetos virtuales en el mundo real. Por ejemplo, permite importar activos incluidos las composiciones realizadas desde Reality Composer, o compilar mallas, materiales y texturas. Además se pueden agregar audios, simulaciones físicas y cambios de entorno.

Los elementos que trabaja ARKIT son varios desde Quick Look, Display, World Tracking (trackeo de superficie, imágenes, objetos, personas y rostros), además permite renderizar efectos y multiusuarios.

Con Reality Composer, ahora cualquier persona puede crear rápidamente prototipos (esta es la palabra clave: prototipos, no una aplicación final) y producir contenido para experiencias de Realidad Aumentada que se integran en aplicaciones con Xcode o exportarlas hacia AR Quick Look y obviamente con formatos USDZ. Si deseas probarlo preliminarmente, se debe tener acceso a la beta del iOS 13. Ahora RealityKit y composer serán tus herramientas indiscutibles.

La instalación de iOS 13 se realiza a través de iTunes que requiere Xcode 11 beta ya instalado o macOS 10.15 beta ya instalado. Yo como usuario de Windows, tendré que esperar hasta setiembre.

Resumen del evento: ARKit 3, RealityKit, Reality Composer

Ejemplos de los nuevas características de ARKit 3

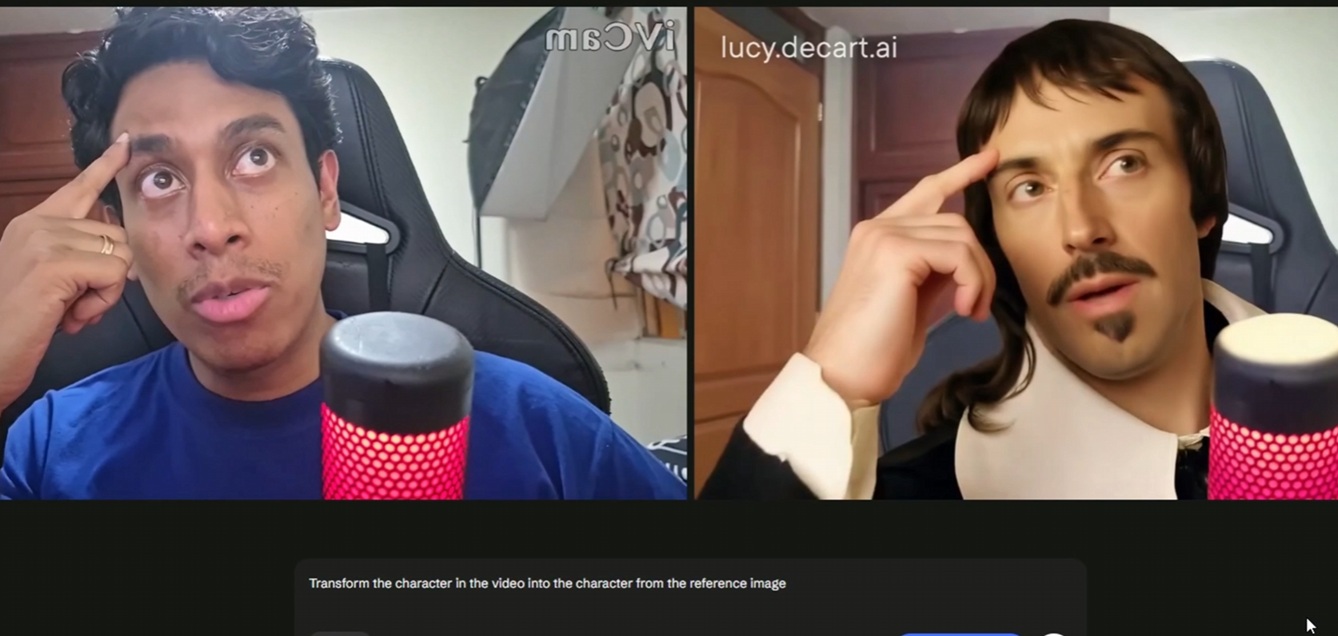

Este es un ejemplo genial de People Occlusion. Esto demuestra la gran capacidad que tendrá ARKit para aplicaciones inmersivas.

Pero por otro lado, usuarios necesitan también oclusión de los objetos pues eso aún no se implementa. Creo que la estrategia de Apple aún no ha sido revelada, pues optar por people occlusion posiblemente sea su gran diferencial.

Por otro lado tenemos a Motion Capture la capacidad de reconocer el movimiento de las personas e imitarlo dentro de un avatar virtual. Esto es un propiedad demostrada en minecraft earth y causó un gran asombro al conocer que se podía producir con baja latencia.

Conoce todas las nuevas características que tendrá ARKit y SceneKit. Mira este video 😉

ARKit 3 Swift Strike

Este ejemplo es increíble, aquí se ve como se puede interactuar con elementos virtuales, oclusión de las personas y claro procesos interactivos. Es necesario resaltar que para aprovechar todos estas bondades posiblemente requerimos de un equipo considerado top de la gama (iPhone XR, iPhone X, etc)

Cuando tenga más noticias de RealityKit o Reality Composer les las actualizaciones. Hasta la próxima

Deja un comentario