La Realidad Aumentada ha sido apoyada constantemente por iniciativas de Google, pero ahora una nueva actualización respecto a su producto de inteligencia artificial puede darle más empuje a la AR gracias a dos nuevas características que es el hand y finger tracking. La IA Google abre las posibilidades a la creación. Posiblemente sea una respuesta ante la llegada de ARKIT 3.

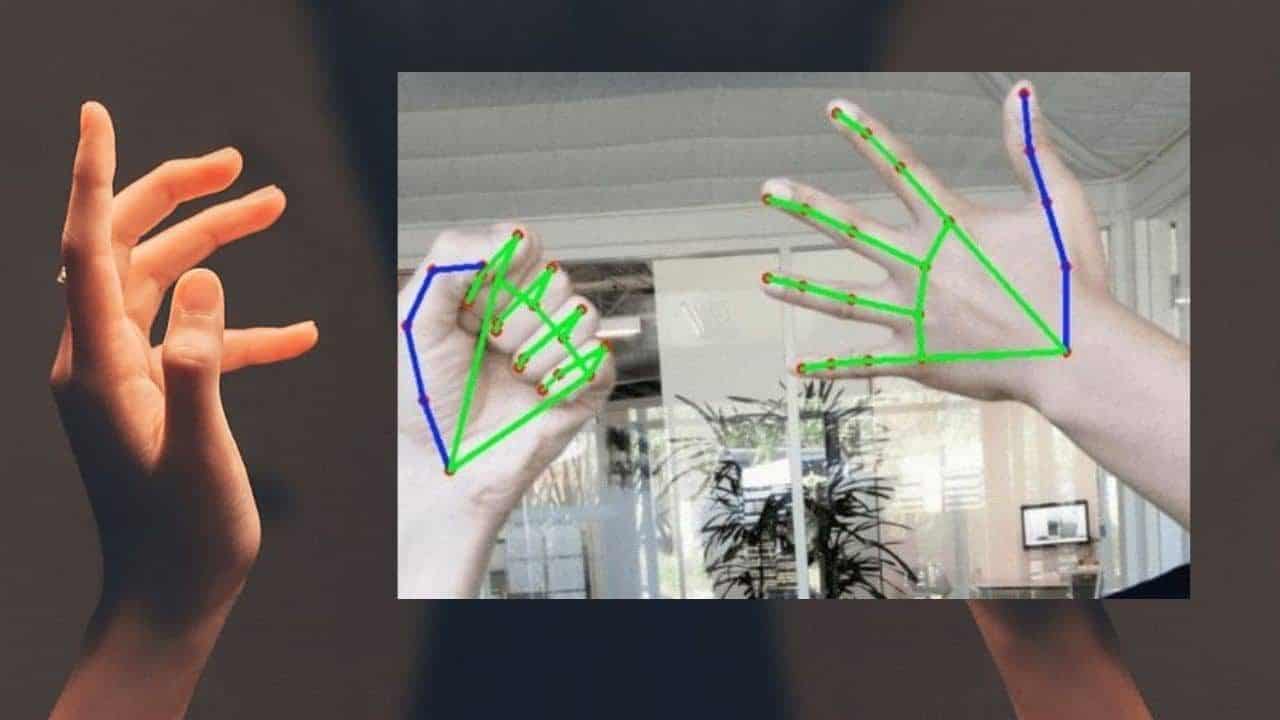

Es evidente que el futuro va hacia ese lado: la erradicación del uso de controles y pasar hacia los patrones gestuales en el aire, por ello esta es un grata noticia pues el hand y finger tracking podrá ayudar a crear nuevas interfaces, dinámicas y aplicaciones. Actualmente la tecnología que utiliza gestos son los Magic Leap y HoloLens 2.

Tendencia Hand y Finger tracking

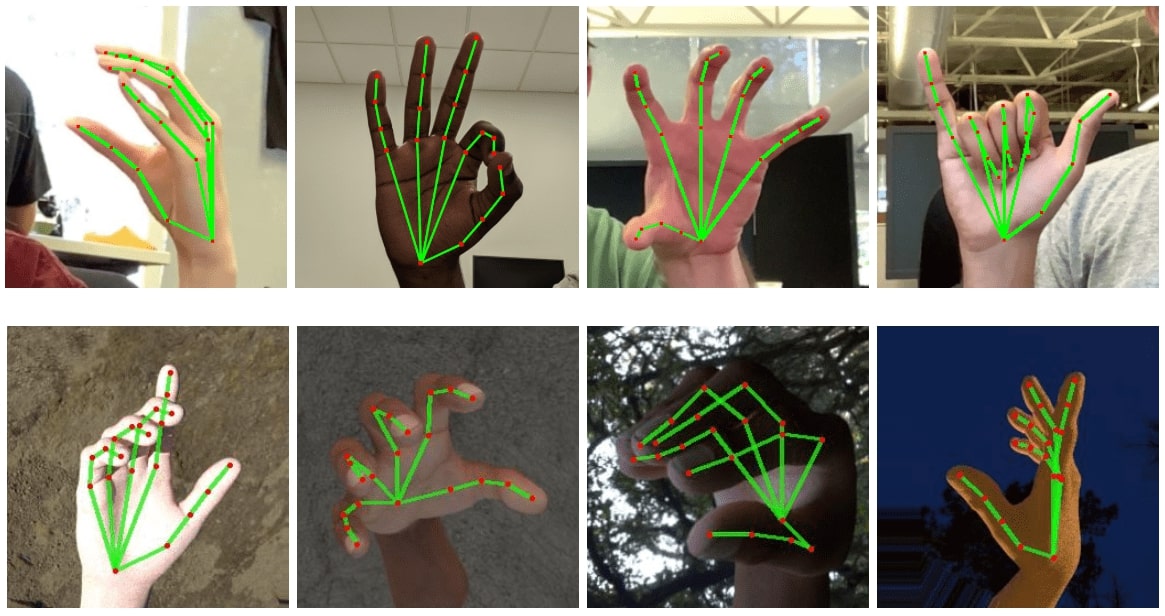

Un nuevo modelo de machine-learning de Google permite implementar complejos controles de gestos con las manos, sin comprar costoso software o hardware dedicado a sensores o cámaras. Es decir, a través de la IA de Google se podrá obtener un resultado decente de movimiento gestual.

Google ha mostrado las nuevas características gracias al framework MediaPipe multiplataforma. En su repositorio se encuentra el código abierto para procesar videos en dispositivos móviles (Android e iOS) y mapear hasta 21 puntos de la mano y dedos. El siguiente paso del equipo será mejorar la precisión y el rendimiento de los modelos de aprendizaje automático con el tiempo. Además, dicho framework no solo hace ese tracking también ha libertado la segmentación de cabello para futuras apps de belleza.

Cabe resaltar que otras plataformas de realidad aumentada como Snapchat o Facebook ya permiten crear filtros de realidad aumentada utilizando la mano como tracker (hand tracker), pero no de manera tan precisa como ahora ha presentado Google.

Proximas implementaciones

Google no piensa omitir el hardware especializado, por ello planea trabajar en conjunto con el sensor de «radar Soli» de Pixel 4 para crear experiencias AR únicas, en su contra parte sería ARKit 3 de Apple y su cámara TrueDepth que posiblemente también se beneficie de este código libre.

Posiblemente más adelante veremos como este hand y finger tracking se empieza a portar en otras plataformas como Unity para su masificación en temas de juegos, experiencias inmersivas, entre otros.

«Esperamos proporcionar esta funcionalidad a la comunidad más amplia de investigación y desarrollo para que aparezcan casos de uso creativos, estimulando nuevas aplicaciones y nuevas vías de investigación«, anunciaron el blog oficial de Google AI

Espero tener tiempo para hacer algunas pruebas simpáticas al respecto 😉

Deja un comentario